Инструкция

1

Для ответа на вопрос, является ли случайная величина нормальной, можно привлечь понятие энтропия Н(x), возникающее в теории информации. Дело в том, что любое дискретное сообщение, формируемое из n символов X={x₁, x₂, … xn}, можно понимать как дискретную случайную величину, заданную рядом вероятностей. Если вероятность использования символа, например х₅ равна Р₅, то такова же и вероятность события X= х₅. Из терминов теории информации возьмем еще понятие количества информации (точнее собственной информации) I(xi)= ℓog(1/P(xi))=- ℓogP(xi). Для краткости записи положите Р(хi)=Рi. Логарифмы здесь берутся по основанию 2. В конкретных выражениях такие основания не записываются. Отсюда, кстати, и двоичная единица (binary digit) – бит.

2

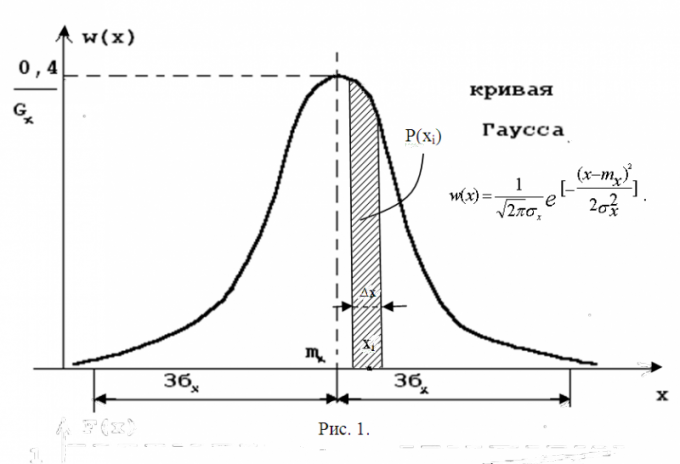

Энтропия – это среднее количество собственной информации в одном значении случайной величины H(x)=M[-ℓogPi]=-∑Pi∙ℓogPi (суммирование ведетcя по i от 1 до n). Ею обладают и непрерывные распределения. Чтобы вычислить энтропию непрерывной случайной величины, представьте ее в дискретном виде. Разбейте участок области значений на малые интервалы ∆х (шаг квантования). В качестве возможного значения возьмите середину соответствующего ∆х, а вместо его вероятности используйте элемент площади Pi≈w(xi)∆x. Ситуацию иллюстрирует рис. 1. На нем, вплоть до мелких подробностей, изображена кривая Гаусса, являющаяся графическим представлением плотности вероятности нормального распределения. Здесь же дана формула плотности вероятности этого распределения. Внимательно рассмотрите эту кривую, сравните ее с теми данными, которыми вы располагаете. Может, ответ на вопрос уже прояснился? Если нет, стоит продолжить.

3

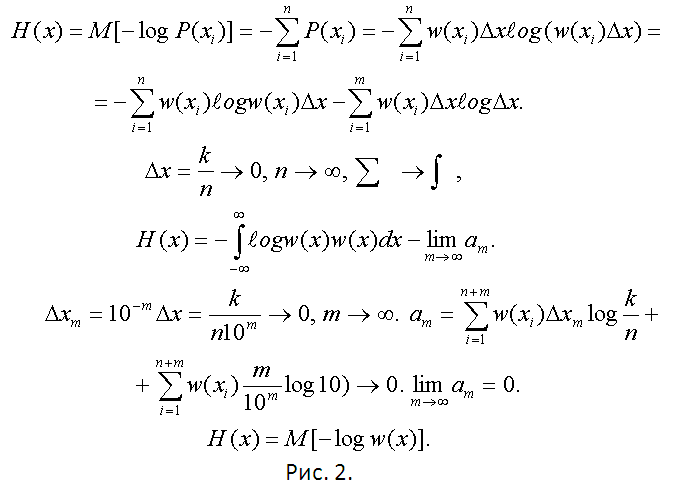

Используйте методику, предложенную на предыдущем шаге. Составьте ряд вероятностей теперь уже дискретной случайной величины. Найдите ее энтропию и предельным переходом при n→∞ (∆x→0) вернитесь к непрерывному распределению. Все выкладки представлены на рис. 2.

4

Можно доказать, что нормальные (гауссовские) распределения обладают максимальной энтропией по сравнению со всеми прочими. Простым вычислением по окончательной формуле предыдущего шага H(x)=M[-ℓogw(x)], найдите эту энтропию. Не понадобится никакое интегрирование. Достаточно свойств математического ожидания. Получите H(x)= ℓog₂(σх√(2πe))= ℓog₂(σх)+ ℓog₂(√(2πe))≈ℓog₂(σx)+2,045. Это возможный максимум. Теперь пользуясь любыми данными, об имеющемся у вас распределении (начиная от простой статистической совокупности) найдите его дисперсию Dx=(σx)². Подставите вычисленную σx в выражение для максимальной энтропии. Вычислите энтропию исследуемой вами случайной величины Н(x).

5

Составьте отношение H(x)/Hmax(x)=ε. Самостоятельно выберите вероятность ε₀, которую можно считать практически равной единице при принятии решения о близости имеющегося у вас распределения и нормального. Назовите ее, скажем, вероятностью правдоподобия. Рекомендуются значения большие, чем 0,95. Если получилось, что ε>ε₀, то вы (с вероятностью не менее ε₀) имеете дело с распределением Гаусса.

Источники:

- Вентцель Е.С. Теория вероятности. – М., Наука. – 1969.